Exmor, Isocell e cia: entenda a importância do sensor na câmera do celular

Enquanto as fabricantes de celulares estão parecem disputar uma corrida para ver quem mostra mais megapixels nas fichas técnicas, e apresentando níveis de zoom extravagantes em seus aparelhos, uma característica muito mais importante da câmera permanece esquecida nas especificações: o tamanho do sensor. Entenda por quê este detalhe é tão crucial para a qualidade de imagem.

Pegue um atalho:

- Tamanho do sensor em polegadas: de tubos analógicos a chips CMOS

- Área efetiva do sensor: tamanho é documento

- Máscara Bayer e outras técnicas: enxergando em cores

- Software de câmera: algoritmo é tudo

- Foco automático: PDAF, 2x2 OCL e mais

Tamanho do sensor em polegadas: de tubos analógicos a chips CMOS

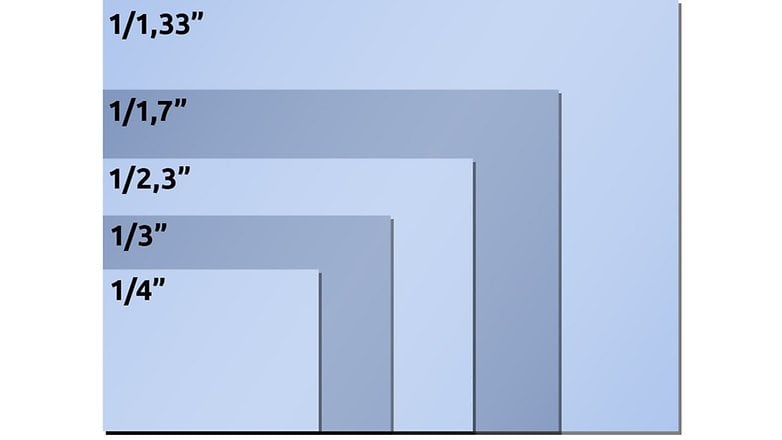

Para começar, um pouco de história: nas especificações das câmeras de celulares, o tamanho do sensor é sempre citado em uma medida exótica na notação 1/xyz polegada, por exemplo 1/1,72 polegada ou 1/2 polegada. Infelizmente, este tamanho não corresponde em nada ao tamanho real do sensor no celular.

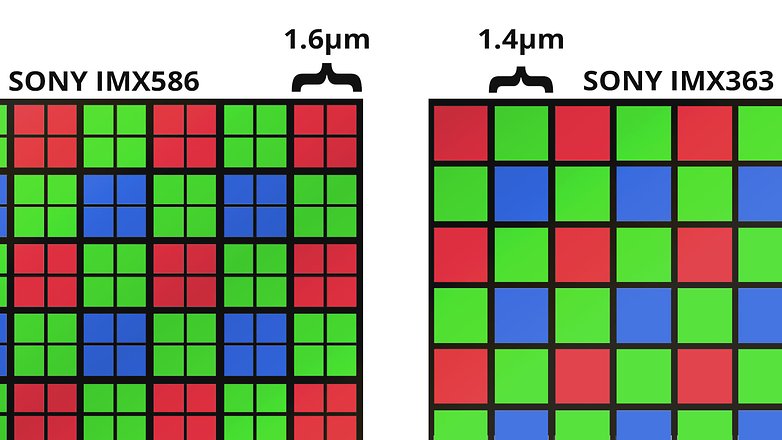

Vejamos a ficha técnica do IMX586: meia polegada deste sensor de 1/2 polegada corresponderia neste caso a 1,27 centímetro. Mas o tamanho real do Sony IMX586 não tem nada a ver com isso. Se multiplicarmos o tamanho dos pixels de 0,8 mícron pela resolução horizontal de 8.000 pontos, obtemos apenas 6,4 milímetros, que é apenas metade. Se primeiro usarmos a horizontal e depois o bom e velho Pitágoras para a diagonal, obtemos 8,0 milímetros. Isso não é nem de perto o bastante.

E aqui está o ponto crucial: as especificações em polegadas foram adotadas há cerca de meio século, quando as câmeras de vídeo ainda dependiam de tubos de vácuo como conversores de imagem. Os departamentos de marketing mantêm a relação aproximada entre a área sensível à luz e diâmetro do tubo até hoje. E por isso um chip CMOS com uma diagonal de 0,31 polegadas é hoje em dia chamado de sensor de 1/2 polegada.

Se você quiser saber o tamanho real de um sensor de imagem, dê uma olhada na folha de dados do fabricante ou na página detalhada da Wikipedia sobre os tamanhos dos sensores de imagem. Ou você pode fazer como no exemplo acima e multiplicar o tamanho do pixel pela resolução horizontal ou vertical.

Área do sensor: quando tamanho é documento

Por que o tamanho do sensor é tão importante? Imagine a luz caindo através da lente sobre o sensor como a chuva caindo do céu. Agora pense que você tem um décimo de segundo para estimar a quantidade de água que está caindo atualmente.

- Isto será relativamente difícil com um copo de shot, pois algumas gotas podem cair no copo em um décimo de segundo se chover muito, ou nenhuma gota se chover pouco ou se tiver um pouco de azar. Em qualquer caso, sua estimativa será muito imprecisa.

- Agora imagine que você tem uma piscina para a mesma tarefa. Com ela, você pode facilmente pegar algumas centenas ou milhares de gotas da chuva e pode estimar com precisão a quantidade de chuva com base na área de superfície.

No caso dos sensores de imagem e a luz acontece o mesmo que com um copo de shot ou uma piscina, e a medição da chuva. Quanto mais escuro, menos fótons os conversores de luz capturam — e menos preciso é o resultado da medição. Essas imprecisões se manifestam posteriormente em erros como ruído de imagem, cores imprecisas, etc.

Tudo bem que em termos absolutos a diferença entre sensores de imagem nos celulares não é tão grande quanto a diferença entre um copo e uma piscina. Mas o já mencionado Sony IMX586 na câmera telefoto do Samsung Galaxy S20 Ultra é cerca de quatro vezes maior em área do que o sensor de 1/4,4 polegada na câmera telefoto do Xiaomi Mi Note 10.

Matriz Bayer e outras técnicas para enxergar colorido

Voltando para nossa comparação acima com a água da chuva, se colocássemos 4.000 vezes 3.000 baldes em um campo aberto, poderíamos determinar a quantidade de chuva caindo com uma "resolução" de 12 megapixels e registrar algum tipo de informação da saturação de água da nuvem passando por cima da região.

Entretanto, se um sensor de imagem com 12 megapixels captasse a quantidade de luz com suas 4.000 por 3.000 armadilhas de fótons, a foto resultante seria preto e branco — porque medimos apenas a quantidade absoluta de luz. Não podemos distinguir as cores nesse exemplo, assim como um balde não pode distinguir o tamanho das gotas de chuva que caem sobre ele. Então como transformar a foto em preto-e-branco em uma foto colorida?

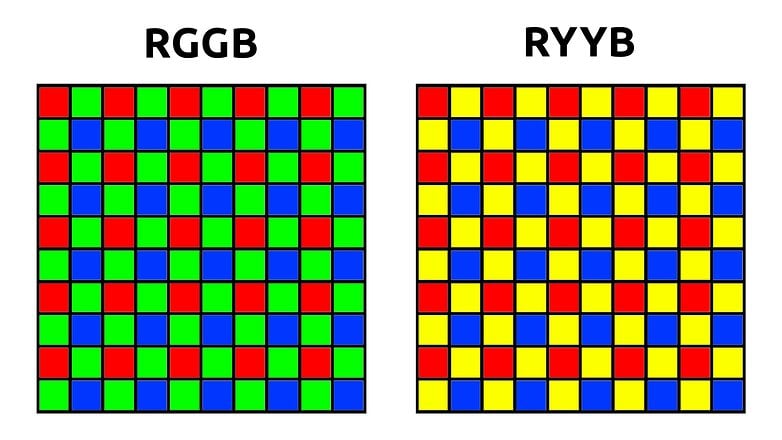

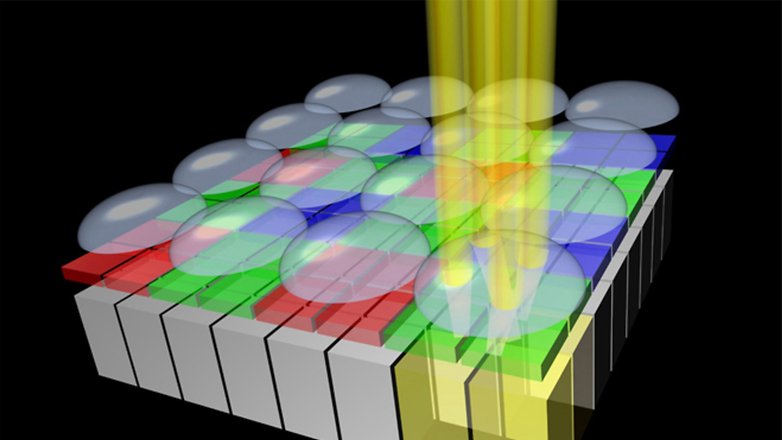

O truque é aplicar uma máscara colorida sobre o sensor, a chamada matriz Bayer (ou filtro Bayer). Isto garante que somente a luz vermelha, azul ou verde atinja os pixels. Com a clássica matriz Bayer com layout RGGB, um sensor de 12 megapixels tem então seis milhões de pixels verdes e três milhões de pixels vermelhos e azuis cada um.

A fim de gerar uma imagem com doze milhões de pixels RGB a partir destes dados, o processamento da imagem normalmente começa com o desmosaico dos pixels verdes (ou interpolação). Usando os pixels vermelhos e azuis ao redor, o algoritmo calcula então — de forma muito simplificada — um valor RGB para cada pixel.

Na prática, os algoritmos de interpolação são muito mais inteligentes, por exemplo, para evitar "franjas" coloridas nas bordas dos objetos. O mesmo processamento é aplicado com os pixels vermelhos e azuis, e uma foto colorida vai então para a memória interna do seu celular.

Quad Bayer e Tetracell

Sejam 48, 64 ou 108 megapixels: a maioria dos atuais sensores de altíssima resolução em celulares tem uma coisa em comum: enquanto o sensor propriamente dito tem 108 milhões de "baldes de água" ou sensores de luz, o filtro Bayer acima dele tem uma resolução quatro vezes menor. Portanto, há quatro pixels sob cada filtro de cor.

É claro, isso é tudo o que os departamentos de marketing mais gostam para usar nas fichas técnicas. Um sensor de 48 megapixels! 108 megapixels! Três sensores de 64 MP! E quando está escuro, os minúsculos pixels podem ser combinados em superpixels maiores para oferecer fotos noturnas melhores.

Paradoxalmente, porém, muitos celulares mais baratos não oferecem nem mesmo a opção de tirar fotos com 48 megapixels — ou até mesmo oferecem uma qualidade de imagem inferior nesse modo em comparação com o modo de 12 megapixels. Em todos os casos que conheço, os celulares também são tão mais lentos ao tirar fotos com resolução máxima, que o aumento moderado na qualidade não vale a pena — especialmente porque 12, 16 ou 27 megapixels são suficientes para o uso diário e não enchem a memória tão rapidamente.

A mensagem de marketing de dezenas de megapixels pode ser ignorada. Mas na prática, os sensores de alta resolução costumam também ser maiores — e a qualidade da imagem se beneficia notavelmente disso.

O sensor SuperSpectrum da Huawei: trocando o verde e amarelo

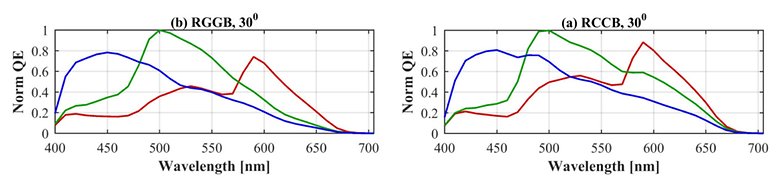

Há ainda algumas técnicas inspiradas na matriz Bayer. A Huawei, como exemplo mais destacado, conta com a chamada matriz RYYB para alguns sensores (ver gráfico acima), na qual o espectro de absorção dos pixels verdes é deslocado para o amarelo. Isto tem a vantagem — pelo menos no papel — de que mais luz é absorvida e mais fótons chegam ao sensor no escuro.

Por outro lado, os comprimentos de onda medidos pelo sensor não estão mais tão uniformemente distribuídos no espectro e tão claramente separados uns dos outros como em um sensor RGGB — caso da linha verde interrompendo sua queda no espectro de onda vermelha no gráfico acima à direita. A fim de manter uma reprodução de cor precisa, aumentam as exigências sobre os algoritmos, que devem posteriormente interpolar os valores de cor RGB.

É impossível prever qual abordagem produzirá as melhores fotos. Neste caso, só os testes práticos e laboratoriais que provam que uma ou outra tecnologia está correta.

Software da câmera: o algoritmo faz a música

Finalmente, gostaria de dizer algumas palavras sobre os algoritmos que acabei de mencionar. Especialmente na era da fotografia computacional, o conceito de fotografia está se tornando difuso. Uma imagem formada por doze fotos individuais ainda é realmente uma fotografia no sentido original?

Uma coisa é certa: a influência dos algoritmos de processamento de imagem é muito maior do que um aumento discreto da área do sensor. Sim, uma diferença de duas vezes a área faz uma grande diferença. Mas um bom algoritmo também compensa muita coisa. A líder global do mercado de sensores, a Sony, é um bom exemplo disso.

Embora a maioria dos sensores de imagem (pelo menos tecnologicamente) venha do Japão, os smartphones Xperia costumam ficar atrás da concorrência em termos de qualidade de imagem. O Japão pode fazer hardware, mas quando se trata de software, os outros estão mais avançados.

E aqui vai outra dica sobre a sensibilidade ISO, que também merece seu próprio artigo: por favor, nunca fique impressionado com os números ISO, pois os sensores de imagem em quase todos os casos* têm uma única sensibilidade ISO nativa que é muito raramente encontrada nas fichas técnicas.

Os valores ISO que o fotógrafo ou o sistema automático da câmera definem durante o clique real são mais como uma compensação — ou seja, um "controle de brilho". O "comprimento" da escala para este controle de brilho pode ser definido livremente, portanto escrever um valor como "ISO 409.600" nas especificações faz tanto sentido quanto escrevê-lo na ficha técnica de um VW Golf... Bom, vamos deixar as coisas assim.

* Existem na verdade alguns sensores "dual ISO" com duas sensibilidades nativas no mercado de câmeras, por exemplo o Sony IMX689 no Oppo Find X2 Pro, pelo menos é isso que o Oppo diz. Caso contrário, é mais provável que você encontre o que está procurando em câmeras profissionais como a BlackMagic PCC 6K.

Autofoco: PDAF, 2x2 OCL e outras técnicas

Finalmente, um pequeno ponto que está diretamente relacionado ao sensor de imagem: o tópico do foco automático. No passado, os celulares determinavam o foco correto usando o foco automático por contraste. Esta é uma detecção lenta e computacionalmente intensiva.

A maioria dos sensores de imagem atuais usa o chamado "autofoco por comparação de fases", também conhecido como PDAF (phase detect autofocus). Neste caso, são instalados pixels especiais de autofoco no sensor que são divididos em duas metades, comparam as fases da luz incidente e podem usá-los para calcular a distância até o objeto. A desvantagem desta tecnologia é que o sensor de imagem é "cego" nestes pontos — e dependendo do sensor, estes pixels cegos de foco podem afetar até três por cento da superfície do componente.

Apenas um lembrete: quanto menor a área, menos luz/água e menor a qualidade de imagem. Além disso, os algoritmos têm que retocar estas imperfeições como seu cérebro faz com o ponto cego.

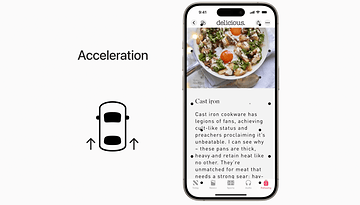

No entanto, há uma abordagem mais elegante que não inutiliza pixels no sensor. Neste caso, as microlentes que já estão presentes no sensor são distribuídas em vários pixels. A Sony, por exemplo, chama isso de 2x2 OCL ou 2x1 OCL, dependendo se as microlentes combinam quatro ou dois pixels.

Em breve dedicaremos um artigo separado e mais detalhado ao foco automático. O que você procura em uma câmera quando compra um novo celular? E sobre quais tópicos em torno da fotografia com celulares você gostaria de ler a respeito? Aguardo com expectativa seus comentários!

Mais artigos sobre câmeras de celulares:

Excelente e completo tutorial

Parabéns Stefan, que matéria altamente técnica e super bem escrita.

Com essas explicações qualquer um pode saber qual o tipo de sensor é o melhor.

Mas ainda existe um calcanhar de Aquiles em todos sensores de câmera para celular, conseguir um milagre no reduzido espaço físico dentro da carcaça do celular, para aumentar o zoom óptico.